Para entrar en contexto debo recapitular lo que se conoce como Procesamiento lineal de información. Este modelo es sobre el cual casi todos los sistemas informáticos trabajan. Existe una entrada de información seguido de un proceso de cálculo para producir un resultado.

Este modelo ha resultado ser exitoso pero a medida que los sistemas evolucionan y se ven en la necesidad de manejar cantidades ingentes de información, el número de procesamientos o iteraciones sobre los datos comienza a ser un tema que genera una barrera. De ahí que todos los esfuerzos del desarrollo de procesadores estén enfocados a crear núcleos que hagan cada vez más ciclos por milisegundo. Pero en realidad se han preocupado poco por crear estructuras inteligentes para el manejo de grandes estructuras de información, ese mar incontenible de datos que se generan a diario.

La neuroplasticidad digital resuelve este problema de fondo ya que el enfoque no es lineal, los principios básicos en los que se fundamenta son los siguientes:

• Las colecciones de datos son indexadas como “mapas fantasmas”, lo cual quiere decir que se convierten grandes cantidades de datos en objetos tipo matriz multidimensional (17 dimensiones) donde la información es ordenada de forma recursiva en subconjuntos, por ejemplo si se tiene un mainconcept llamado “Mundo” que representa el total de información, se pueden acceder a subconcepts como “País” limitando el rango o profundizar tanto como sea necesario pudiendo acceder a subconcepts como “Estado” o “Municipio”; todo esto en una estructura jerárquica.

• Si “mapas fantasmas” son mi entrada de información el procesamiento se hace para la búsqueda de un “conjunto solución” que no es más que otra matriz finita de ecuaciones lineales para las cuales un “mapa fantasma” representa la solución puntual en un “problema ambiente” dado.

• Tanto los “mapas fantasma”, los “conjunto solución” y los “problema ambiente” son objetos programáticos que son almacenados en base de datos, todos ellos son estructuras complejas de información gestionados por el núcleo de neuroplasticidad y poseen la característica clave de ser metamórficos.

• El metamorfismo de las estructuras es la característica clave de adaptabilidad que provee de flexibilidad al núcleo para desarrollar soluciones creativas. Esta característica funciona aislando “puntos de inflexión” lo que quiere decir que los datos que componen la matriz puntual tienen la libertad de ser mayores o menores pero en conjunto estas deformaciones deben disiparse, por ejemplo un vector [2,4,6] tiene la libertad de mutar en el vector primo [1,5,6] y ser probado como una solución alterna. La flexibilidad es multinivel y depende de las búsquedas de “conjunto solución” y de l “problema ambiente”

• El motor de cálculo está basado en una red nodal de OPE (Objetos de Procesamiento Estocástico). El inicio del cálculo para la búsqueda de un “conjunto solución” es la construcción de una colección finita de OPEs que cuentan con una serie de características o variables que afectan el resultado puntual que generan. Actualmente el modelo de OPE cuanta con 255 variables en una colección denominada ECO ( Esencia de Cálculo del Objeto) El ECO de cada objeto es almacenado también en base de datos. La búsqueda del conjunto solución se hace bajo el siguiente algoritmo:

o Se carga el “Problema Ambiente”

o Se cargan los “Mapas fantasmas” relacionados

o Se construye la red neuronal de OPEs

o Se definen los ciclos de búsqueda en un numero N finito

o Cada OPE toma al azar una cantidad K de datos puntuales de la matriz(es) “Mapa fantasma”

o Se evalúan todos los resultados individuales de los OPEs

o De todos los resultados “similares” con un rango de tolerancia se identifican los OPEs que los generaron

o Se destruyen los OPEs que no concuerdan con la mayoría, dejando un numero J <(K/Q) donde Q es una variable aleatoria menor que (K/16) o Se generan los nuevos OPEs con características similares a la generación anterior para repoblar la red neuronal o El proceso es cíclico y se detiene cuando todos los OPEs convergen en “similitud de cálculo” o Se extraen y almacenan los ECOs de cada OPE. o Se construye un OPE –Elite con las 255 variables más exitosas en el ciclo de iteraciones estocásticas o Con este objeto de cálculo se construye lo que denomino “Beta Solución Puntual” que es una matriz con la misa estructura de “Conjunto Solución” o Se prueba la “Beta Solución” para determinar si satisface puntualmente condiciones del “Problema Ambiente” o Si después de N pruebas aleatorias se satisfacen los resultados la “BetaSolucion” se convierte en “Conjunto Solucion” de lo contrario se destruye el OPE-Elite y se construye otro nuevo para un nuevo ciclo. Si después de K cantidad de ciclos no hay satisfacción de resultados se determina que no hay solución para la combinación de “Mapas Fantasma” y “Problema Ambiente” o Una vez correlacionados la información y sus “conjunto solución” se almacena todo en base de datos y se abre la posibilidad para consultas puntuales. Este modelo puede tener una amplia gama de aplicaciones pero una de las más interesantes es en el campo de DataMinig Autónomo. Lo cual puede ser algo así como tener una herramienta que genere balances, proyecciones, sugerencias de optimización o una gama de resultados complejos con una simple consulta a los conjuntos solución. El siguiente es un mapa conceptual de los módulos de Neuroplasticidad y su aplicación a Bussines Inteligence.

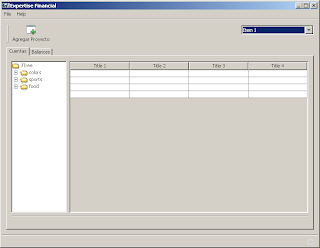

De hecho actualmente la aplicación de entrada de datos para aplicarlos al modelo esta en construcción y es llamada Expertise Financial que es a simple vista un manejador de cuentas contables pero de fondo las consultas y los resultados serán operados por este modelo.

Autor del Modelo:

Luis Horacio Muñiz